前言

Skip!

Skip!!

Skip!!!

前期准备

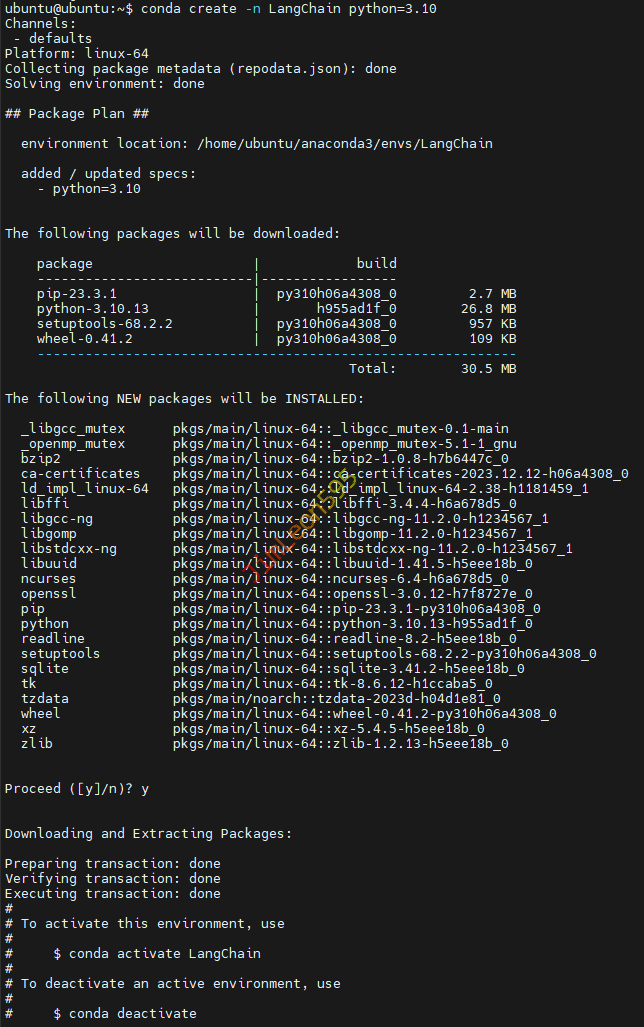

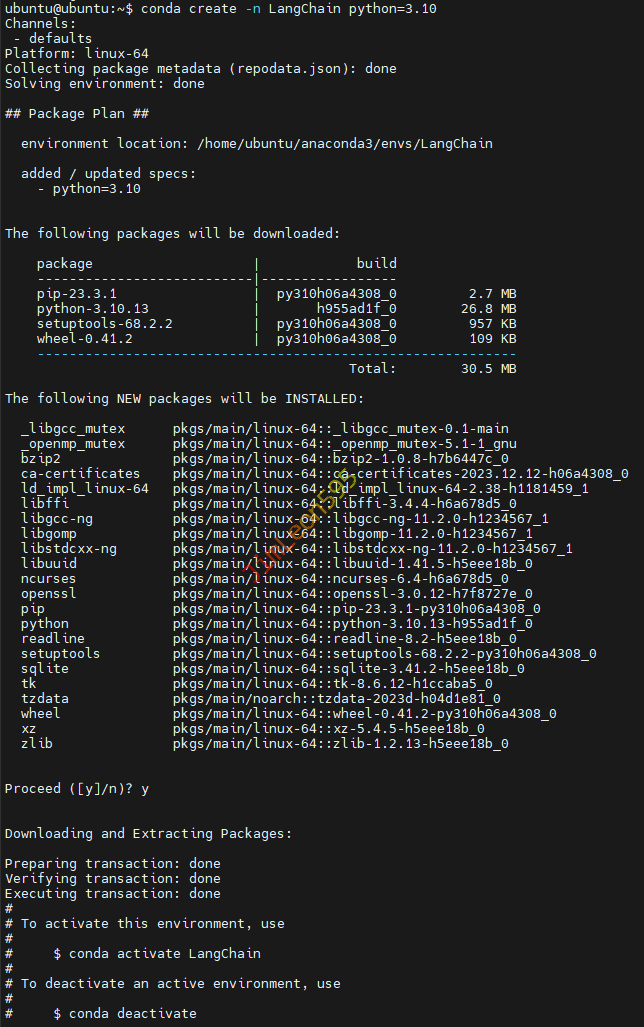

创建虚拟环境

1

| conda create -n LangChain python=3.11

|

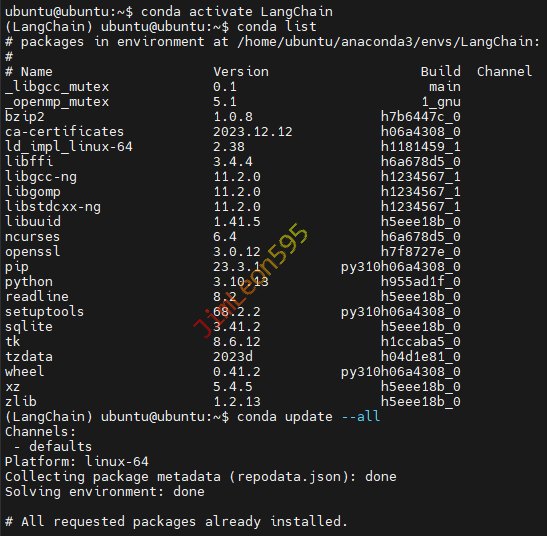

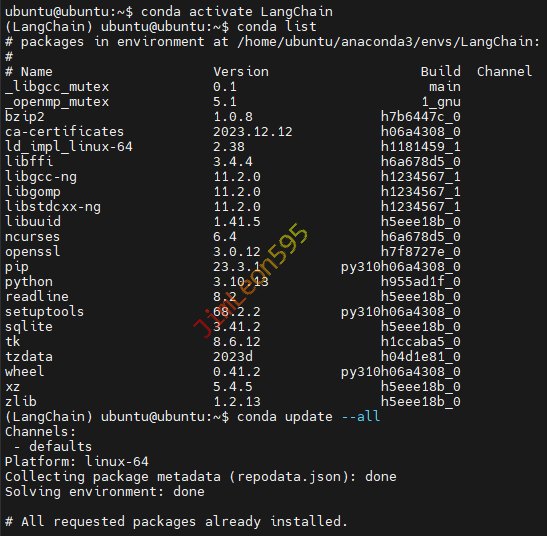

进入虚拟环境

1

| conda activate LangChain

|

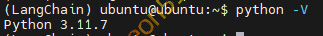

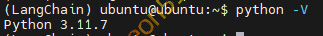

Python 版本

LangChain 基础配置

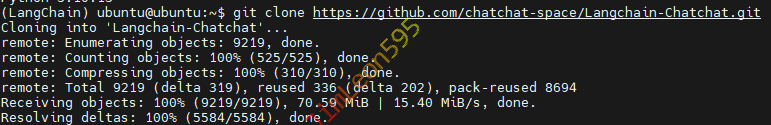

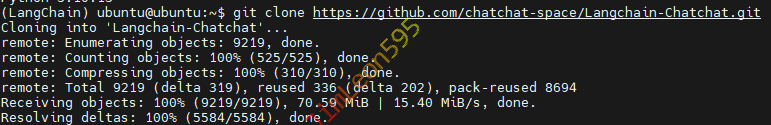

拉取源码

1

| git clone https://github.com/chatchat-space/Langchain-Chatchat.git

|

进入目录

1

| cd ./Langchain-Chatchat/

|

安装依赖

1

2

3

| python3 -m pip install -r requirements.txt

python3 -m pip install -r requirements_api.txt

python3 -m pip install -r requirements_webui.txt

|

设置指定版本依赖

SecGPT 基于 BaiChuan 然后环境配的一塌糊涂

1

2

| python3 -m pip install --upgrade torch torchvision torchaudio

python3 -m pip install vllm==0.1.4 transformers==4.32.0

|

初始化配置文件

创建配置文件

1

| python3 copy_config_example.py

|

修改模型配置文件

- 修改

model_config.py

1

| sudo vim model_config.py

|

- 添加模型存放目录

1

| MODEL_ROOT_PATH = "/home/ubuntu/model/"

|

模型下载

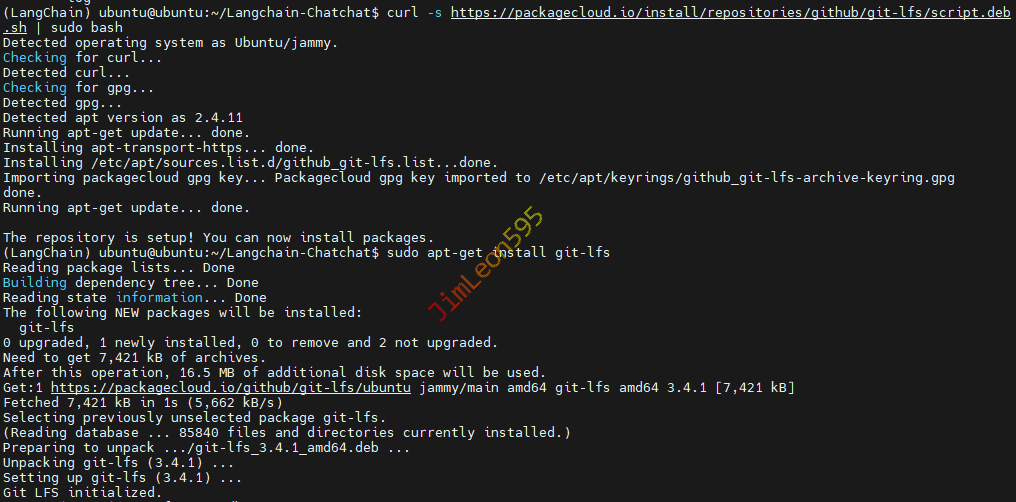

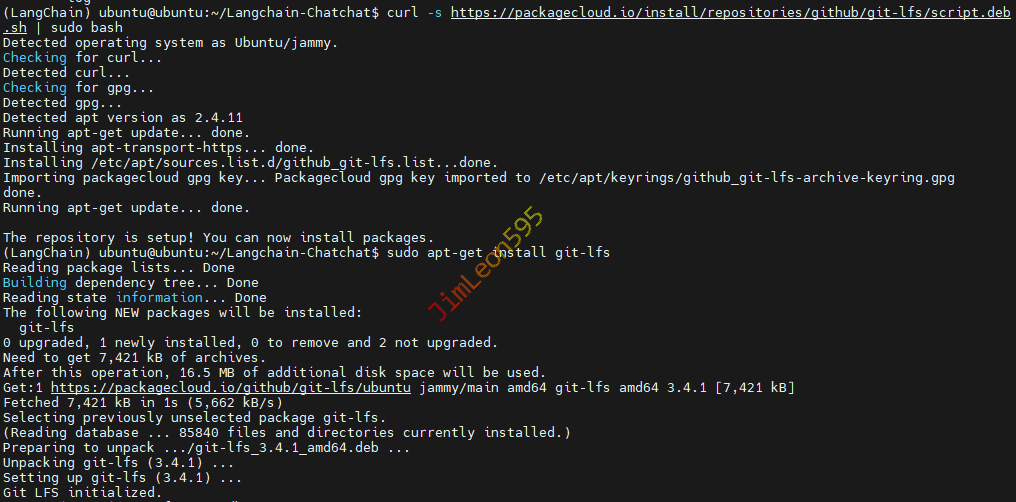

安装 Git LFS

- 下载

Git LFS

1

2

| curl -s https://packagecloud.io/install/repositories/github/git-lfs/script.deb.sh | sudo bash

sudo apt-get install git-lfs

|

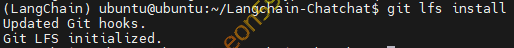

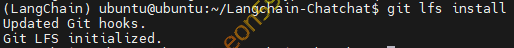

- 验证

Git LFS 安装

模型下载

- 创建存放模型的文件夹

1

2

| mkdir /home/ubuntu/model

cd /home/ubuntu/model

|

- 下载官方依赖模型

1

| git clone https://huggingface.co/BAAI/bge-large-zh-v1.5 BAAI/bge-large-zh-v1.5

|

1

| git clone https://huggingface.co/BAAI/bge-reranker-large BAAI/bge-reranker-large

|

1

| git clone https://huggingface.co/THUDM/chatglm3-6b-32k THUDM/chatglm3-6b-32k

|

初始化知识库

1

| python3 init_database.py --recreate-vs

|

一键驱动

修改启动配置文件

1

2

3

4

5

6

|

args.gpus = "0,1"

args.max_gpu_memory = "22GiB"

args.num_gpus = 2

|

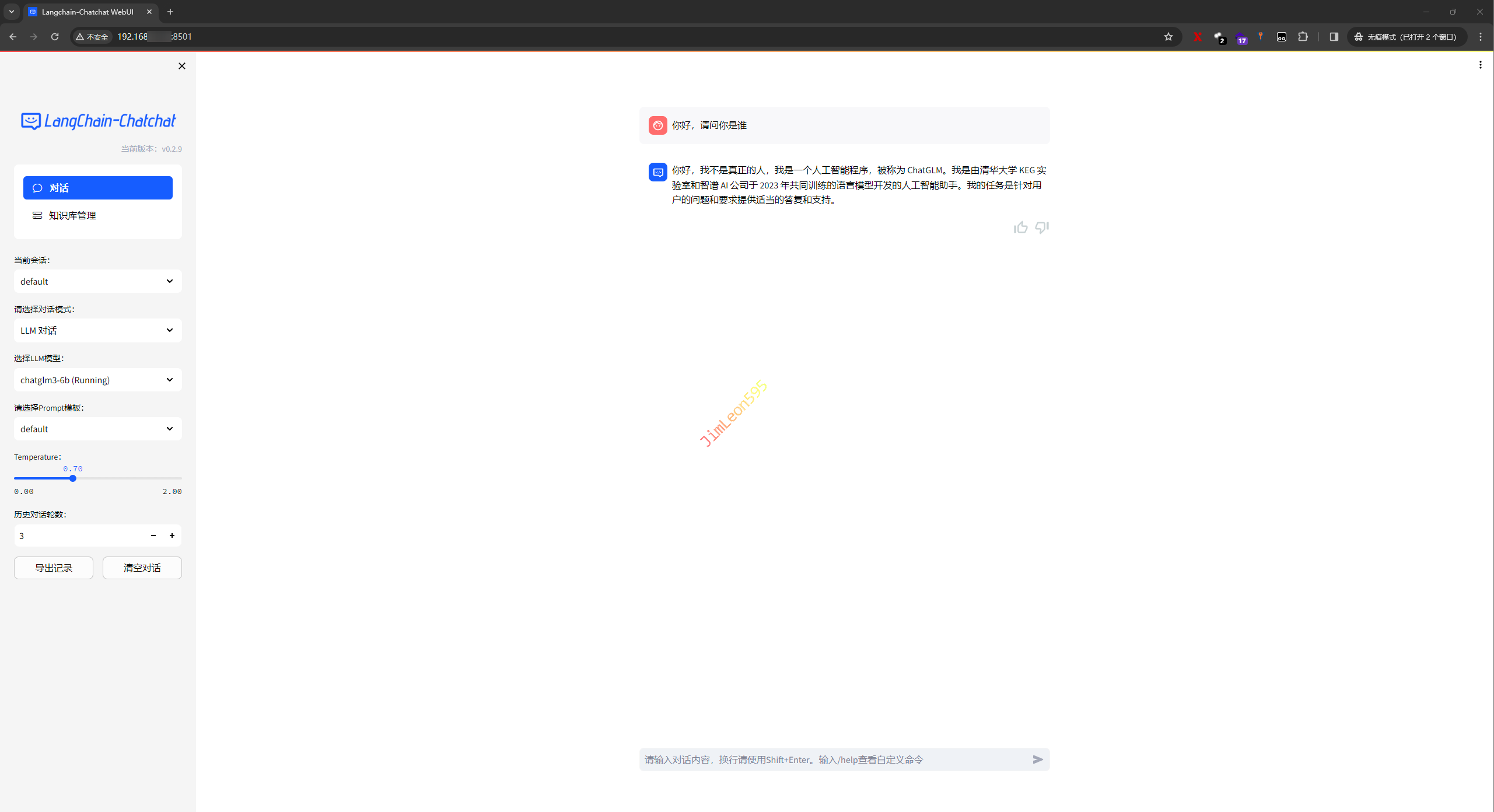

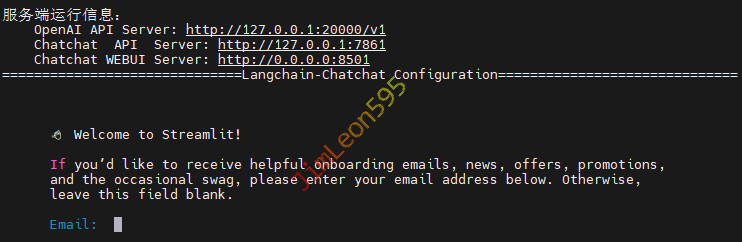

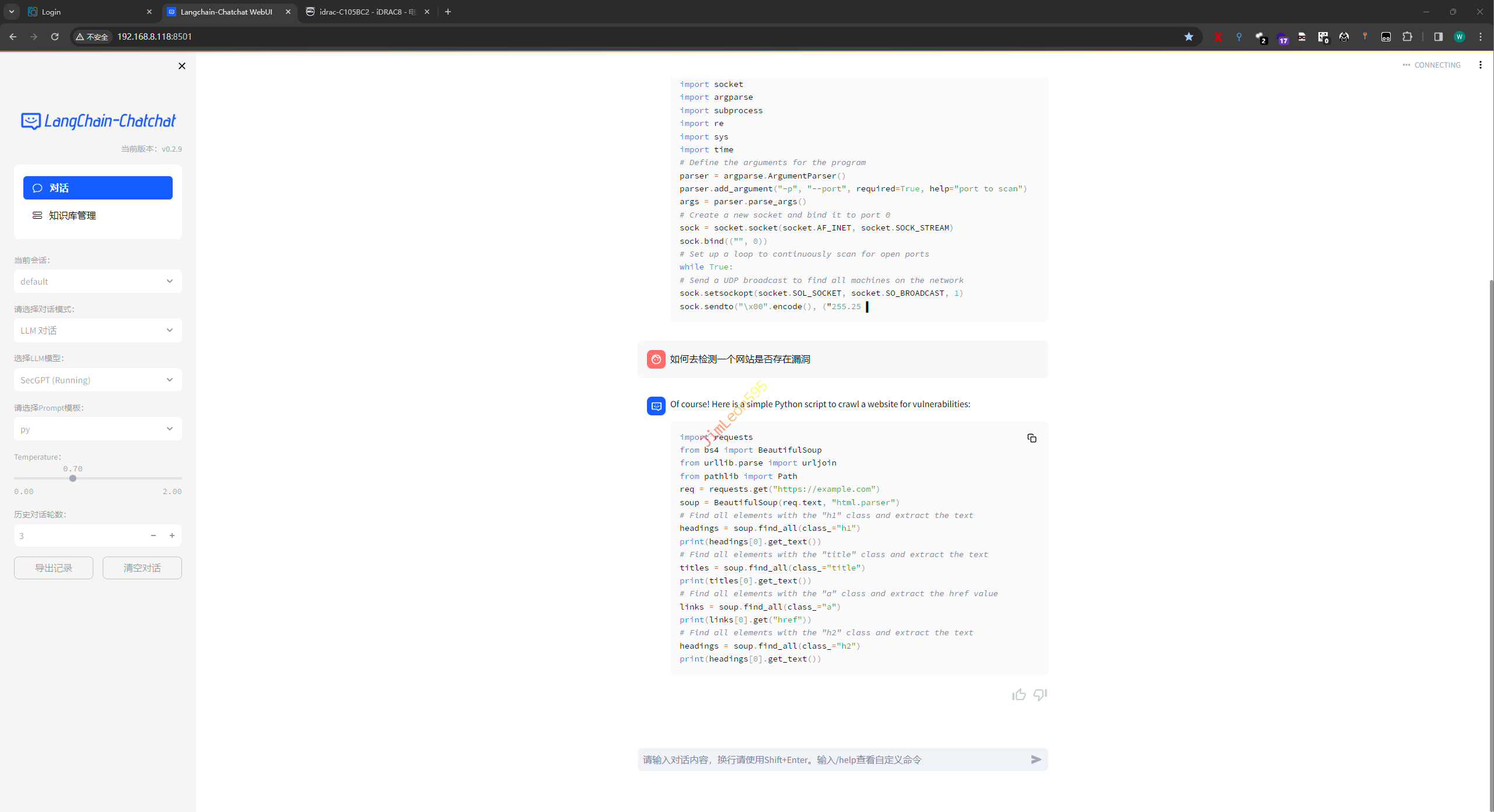

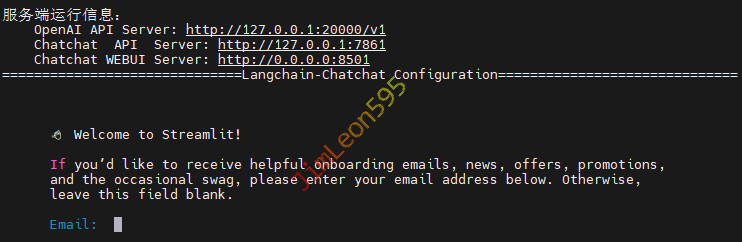

运行成功?

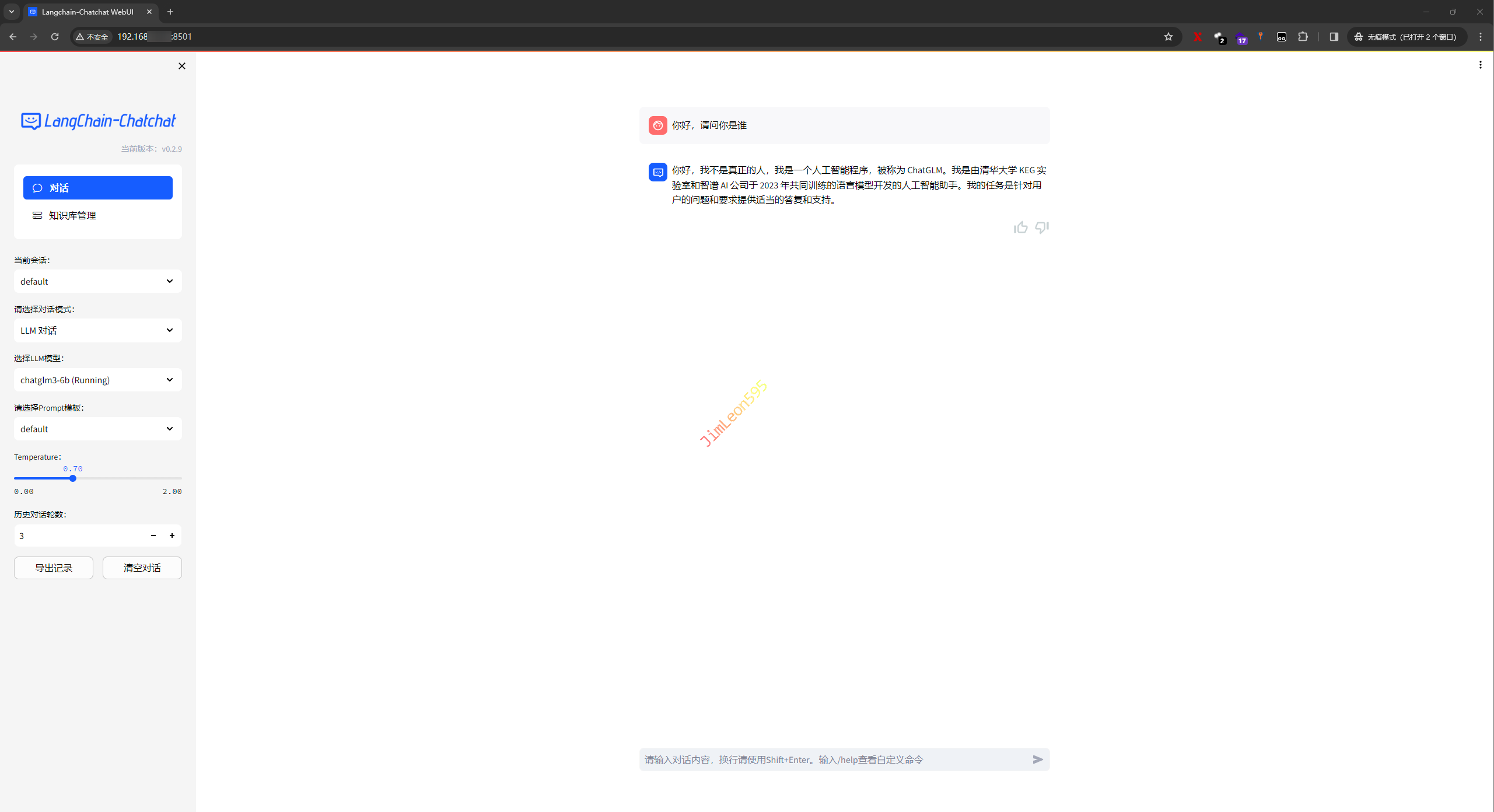

CLI 界面

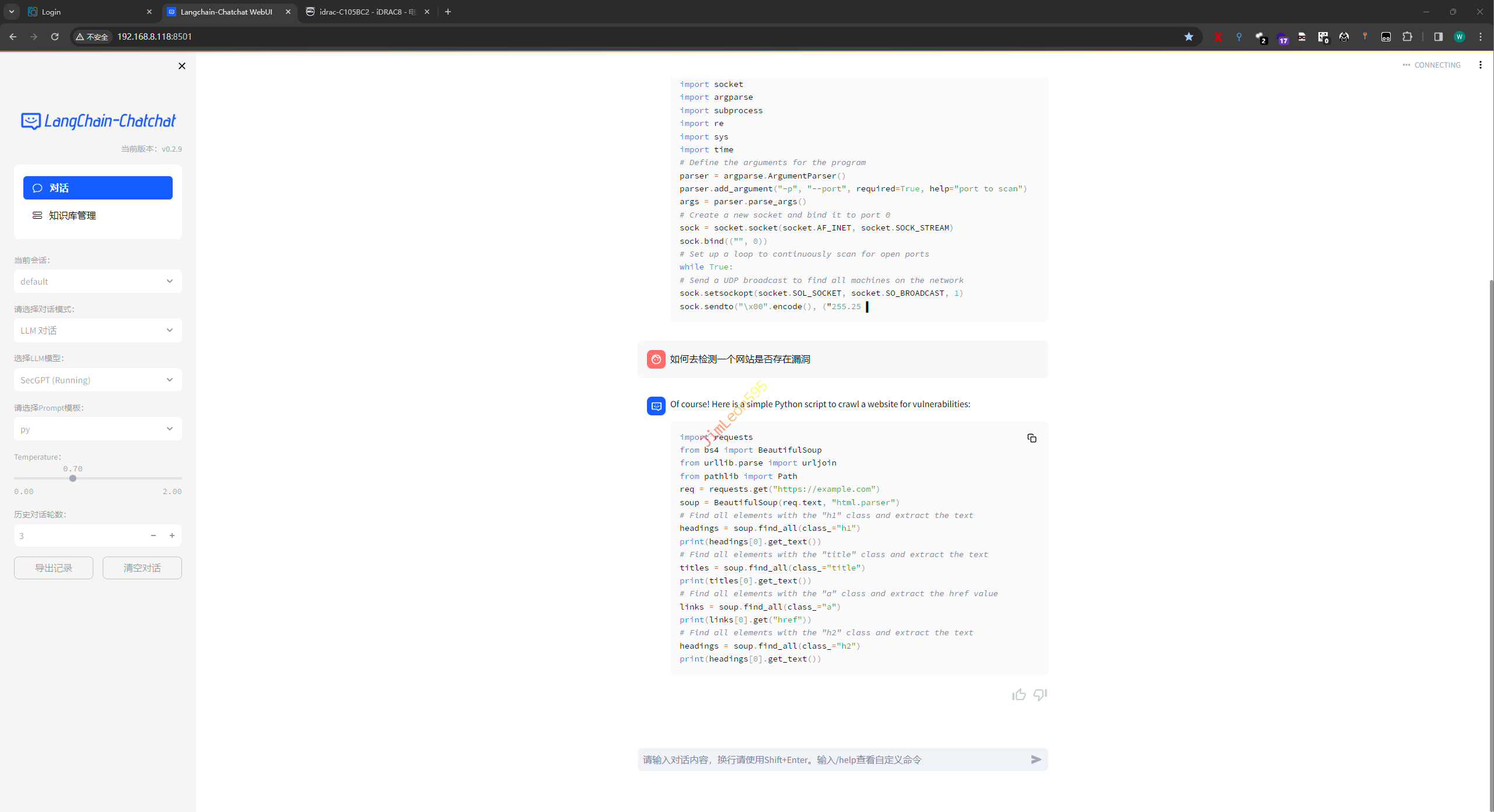

GUI 界面

参考 & 引用

https://github.com/chatchat-space/Langchain-Chatchat/blob/master/README.md